Von James Glanz, New York Times

* 22. Sept. 2012

SANTA CLARA, Kalifornien - Jeff Rothschilds Maschinen bei Facebook hatten ein Problem, von dem er wusste, dass er es sofort lösen musste. Sie waren dabei zu schmelzen.

Das Unternehmen hatte hier einen 40 mal 60 Fuß großen Mietraum mit Racks von Computerservern vollgestopft, die zum Speichern und Verarbeiten von Informationen aus den Mitgliederkonten benötigt wurden. Der Strom, der in die Computer floss, überhitzte die Ethernet-Buchsen und andere wichtige Komponenten.

Rothschild, der technische Leiter des Unternehmens, ging mit einigen Mitarbeitern auf Entdeckungsreise, um alle Ventilatoren zu kaufen, die sie finden konnten - "Wir haben alle Walgreens in der Gegend ausgeräumt", sagte er -, um kühle Luft auf die Geräte zu blasen und die Website vor dem Ausfall zu bewahren.

Das war Anfang 2006, als Facebook nur etwa 10 Millionen Nutzer und einen Hauptserver hatte. Heute erfordern die von fast einer Milliarde Menschen erzeugten Informationen überdimensionale Versionen dieser Einrichtungen, die als Rechenzentren bezeichnet werden, mit Reihen von Servern, die sich über Hunderttausende von Quadratmetern erstrecken, und alle mit industriellen Kühlsystemen.

Sie sind nur ein Bruchteil der Zehntausenden von Rechenzentren, die jetzt existieren, um die gesamte Explosion digitaler Informationen zu unterstützen. Jeden Tag werden gewaltige Datenmengen in Bewegung gesetzt, wenn Menschen mit einem harmlosen Klick oder Fingertipp Filme auf iTunes herunterladen, den Kontostand ihrer Kreditkarten auf der Visa-Website überprüfen, Yahoo-E-Mails mit angehängten Dateien verschicken, Produkte auf Amazon kaufen, auf Twitter posten oder online Zeitungen lesen.

Eine einjährige Untersuchung der New York Times hat gezeigt, dass diese Grundlage der Informationsindustrie in krassem Widerspruch zu ihrem Image der schlanken Effizienz und Umweltfreundlichkeit steht.

Die meisten Rechenzentren sind so konzipiert, dass sie riesige Mengen an Energie in einer unangemessen verschwenderischen Weise verbrauchen, wie Interviews und Dokumente zeigen. Online-Unternehmen lassen ihre Anlagen in der Regel rund um die Uhr mit maximaler Kapazität laufen, egal wie hoch die Nachfrage ist. Infolgedessen können die Rechenzentren 90 Prozent oder mehr des Stroms, den sie aus dem Netz beziehen, verschwenden, so die Times.

Um sich gegen Stromausfälle zu schützen, sind sie außerdem auf eine Reihe von Generatoren angewiesen, die Dieselabgase ausstoßen. Die Verschmutzung durch Rechenzentren wird von den Behörden zunehmend als Verstoß gegen die Vorschriften zur Luftreinhaltung gewertet, wie aus Dokumenten hervorgeht. Im Silicon Valley sind viele Rechenzentren im Toxic Air Contaminant Inventory der Landesregierung aufgeführt, einer Liste mit den größten stationären Dieselverschmutzern in der Region.

Nach Schätzungen von Branchenexperten, die für die Times zusammengestellt wurden, verbrauchen die digitalen Lagerhäuser weltweit etwa 30 Milliarden Watt Strom, was in etwa der Leistung von 30 Kernkraftwerken entspricht. Den Schätzungen zufolge entfallen ein Viertel bis ein Drittel dieses Verbrauchs auf die Rechenzentren in den Vereinigten Staaten.

"Für die meisten Menschen, selbst für Branchenkenner, ist es erschütternd, die Zahlen und die schiere Größe dieser Systeme zu verstehen", so Peter Gross, der an der Entwicklung von Hunderten von Rechenzentren beteiligt war. "Ein einziges Rechenzentrum kann mehr Strom verbrauchen als eine mittelgroße Stadt".

Die Energieeffizienz variiert stark von Unternehmen zu Unternehmen. Im Auftrag der Times analysierte das Beratungsunternehmen McKinsey & Company den Energieverbrauch von Rechenzentren und stellte fest, dass diese im Durchschnitt nur 6 bis 12 Prozent des Stroms, mit dem ihre Server betrieben werden, für die Durchführung von Berechnungen verwenden. Der Rest diente im Wesentlichen dazu, die Server im Leerlauf zu halten und für den Fall eines Aktivitätsanstiegs, der den Betrieb verlangsamen oder zum Absturz bringen könnte, bereitzuhalten.

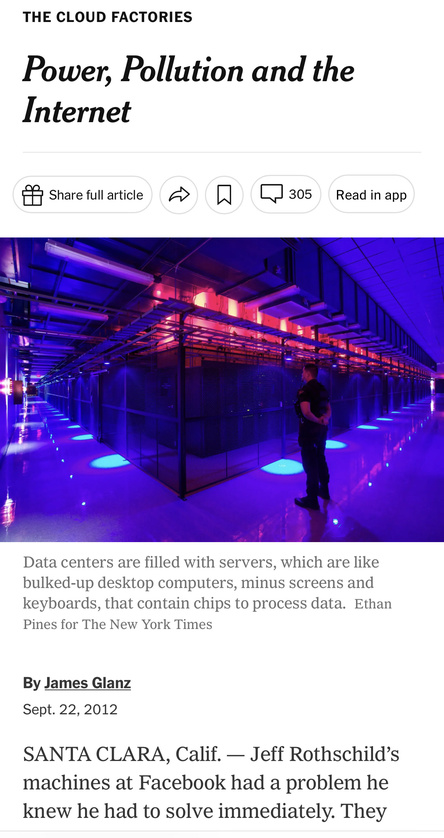

Ein Server ist eine Art vergrößerter Desktop-Computer ohne Bildschirm und Tastatur, der Chips zur Datenverarbeitung enthält. Im Rahmen der Studie wurden rund 20.000 Server in etwa 70 großen Rechenzentren untersucht, die das gesamte Spektrum der Wirtschaft abdecken: Pharmaunternehmen, militärische Auftragnehmer, Banken, Medienunternehmen und Regierungsbehörden.

"Dies ist ein schmutziges Geheimnis der Branche, und niemand will der Erste sein, der sich schuldig bekennt", sagte ein leitender Angestellter der Branche, der nicht genannt werden möchte, um den Ruf seines Unternehmens zu schützen. "Wären wir eine Fertigungsindustrie, wären wir sofort aus dem Geschäft".

Diese physische Realität der Daten ist weit entfernt von der Mythologie des Internets, wo das Leben in der "virtuellen" Welt stattfindet und alle Arten von Daten in der "Cloud" gespeichert werden.

Die ineffiziente Energienutzung wird weitgehend durch eine symbiotische Beziehung zwischen den Nutzern, die eine sofortige Reaktion auf einen Mausklick verlangen, und den Unternehmen, die ihr Geschäft aufs Spiel setzen, wenn sie diese Erwartung nicht erfüllen, bestimmt.

Selbst wenn der Strom auf Hochtouren läuft, reicht das nicht aus, um die Branche zufrieden zu stellen. Zusätzlich zu den Generatoren verfügen die meisten großen Rechenzentren über riesige, sich drehende Schwungräder oder Tausende von Blei-Säure-Batterien - viele davon ähnlich wie Autobatterien -, um die Computer im Falle eines Netzausfalls von nur wenigen Hundertstelsekunden mit Strom zu versorgen - eine Unterbrechung, die die Server zum Absturz bringen könnte.

"Es ist eine Verschwendung", sagte Dennis P. Symanski, ein leitender Forscher am Electric Power Research Institute, einer gemeinnützigen Industriegruppe. "Das sind zu viele Versicherungspolicen."

Mindestens ein Dutzend großer Rechenzentren wurde allein in Virginia und Illinois wegen Verstößen gegen die Luftqualitätsvorschriften verwarnt, wie aus staatlichen Unterlagen hervorgeht. Amazon wurde über einen Zeitraum von drei Jahren in Nord-Virginia mit mehr als 24 Verstößen konfrontiert, darunter der Betrieb einiger seiner Generatoren ohne eine grundlegende Umweltgenehmigung.

Einige Unternehmen geben an, dass sie umfassend überarbeitete Software und Kühlsysteme einsetzen, um die Energieverschwendung zu verringern. Dazu gehören Facebook und Google, die auch ihre Hardware überarbeitet haben. Dennoch verbrauchen die Rechenzentren von Google nach jüngsten Angaben fast 300 Millionen Watt und die von Facebook etwa 60 Millionen Watt.

Viele dieser Lösungen sind ohne Weiteres verfügbar, aber in einer risikoscheuen Branche zögern die meisten Unternehmen laut Branchenexperten, umfassende Änderungen vorzunehmen.

Die Verbesserung oder auch nur die Bewertung des Bereichs wird durch die Geheimhaltung einer Branche erschwert, die weitgehend auf dem Zugriff auf die persönlichen Daten anderer Menschen beruht.

Aus Sicherheitsgründen geben die Unternehmen in der Regel nicht einmal die Standorte ihrer Rechenzentren bekannt, die in anonymen Gebäuden untergebracht sind und streng geschützt werden. Die Unternehmen schützen ihre Technologie auch aus Wettbewerbsgründen, sagt Michael Manos, ein langjähriger Branchenexperte. "All diese Dinge spielen ineinander und fördern diese geschlossene, nur für Mitglieder zugängliche Gruppe", sagte er.

Diese Geheimhaltung erstreckt sich oft auch auf die Energienutzung. Erschwerend kommt hinzu, dass keine einzelne Regierungsbehörde die Befugnis hat, die Branche zu überwachen. Tatsächlich war die Bundesregierung nicht in der Lage festzustellen, wie viel Energie ihre eigenen Rechenzentren verbrauchen, so Beamte, die an einer im letzten Jahr durchgeführten Umfrage beteiligt waren.

Die Umfrage ergab jedoch, dass die Zahl der Rechenzentren der Bundesregierung von 432 im Jahr 1998 auf 2.094 im Jahr 2010 gestiegen ist.

Um die Branche zu untersuchen, beschaffte sich die Times Tausende von Seiten lokaler, staatlicher und bundesstaatlicher Aufzeichnungen, einige davon durch Gesetze zur Informationsfreiheit, die über Industrieanlagen geführt werden, die große Mengen an Energie verbrauchen. Von den Umweltbehörden wurden Kopien von Genehmigungen für Stromerzeuger und Informationen über deren Emissionen eingeholt, die dazu beitrugen, einige Standorte von Rechenzentren und Details zu deren Betrieb zu ermitteln.

Neben der Überprüfung der Unterlagen von Stromversorgern besuchte die Times auch Rechenzentren im ganzen Land und führte Hunderte von Interviews mit derzeitigen und ehemaligen Mitarbeitern und Auftragnehmern.

Einige Analysten warnen davor, dass Unternehmen, die ihre Praktiken nicht ändern, angesichts der steigenden Datenmenge und des steigenden Energieverbrauchs irgendwann vor einem Umbruch in einer Branche stehen könnten, die schon öfters große Umwälzungen erlebt hat, so auch beim Platzen der ersten Internetblase in den späten 1990er Jahren.

"Das ist einfach nicht tragbar", sagte Mark Bramfitt, ein ehemaliger leitender Angestellter eines Versorgungsunternehmens, der heute als Berater für die Energie- und Informationstechnologiebranche tätig ist. "Sie werden auf eine Mauer stoßen".

Bytes in Milliardenhöhe

In einem FC-Barcelona-T-Shirt und karierten Bermudashorts schritt Andre Tran durch ein Yahoo-Rechenzentrum in Santa Clara, wo er als Site Operations Manager tätig war. Der Bereich von Herrn Tran - es gab unter anderem Server für Fantasy-Sport und Foto-Sharing - war ein gutes Beispiel für die zahllosen Computerräume, in denen die schwappenden Datenfluten des Planeten durchlaufen oder zur Ruhe kommen.

Ein Gang nach dem anderen mit Servern, deren gelbe, blaue und grüne Lichter leise blinkten, stand auf einem weißen Boden, der von kleinen runden Löchern durchbrochen war, die kalte Luft ausspuckten. In jedem Server befanden sich die sich drehenden Festplatten, auf denen die Daten gespeichert waren. Der einzige Hinweis darauf, dass das Zentrum von Yahoo betrieben wurde, dessen Name nirgends zu sehen war, fand sich in einem Gewirr von Kabeln, die in den für das Unternehmen typischen Farben Lila und Gelb gefärbt waren.

"Darauf könnten sich Tausende von E-Mails befinden", sagte Herr Tran und zeigte auf einen Lagergang. "Die Leute bewahren alte E-Mails und Anhänge ewig auf, da braucht man eine Menge Platz.

Dies ist das alltägliche Gesicht digitaler Informationen - Spielerstatistiken, die in Server fließen, die Fantasiepunkte und Ligaranglisten berechnen, Schnappschüsse von fast vergessenen Urlauben, die für immer in Speichergeräten aufbewahrt werden. Erst wenn man die Wiederholungen dieser und ähnlicher Transaktionen zusammenzählt, werden sie beeindruckend.

Jedes Jahr werden die Chips in den Servern schneller und die Speichermedien dichter und billiger, aber die rasende Datenproduktion wird noch eine Stufe höher.

Jeremy Burton, ein Experte für Datenspeicherung, sagte, dass der datenintensivste Kunde, mit dem er vor 10 Jahren in einem Computertechnologieunternehmen arbeitete, etwa 50.000 Gigabyte in seiner gesamten Datenbank hatte. (Die Datenspeicherung wird in Bytes gemessen. Der Buchstabe N zum Beispiel benötigt 1 Byte zum Speichern. Ein Gigabyte ist eine Milliarde Bytes an Informationen.)

Heute werden bei der Erstellung eines einzigen 3D-Animationsfilms etwa eine Million Gigabyte in einem Rechenzentrum verarbeitet und gespeichert, so Burton, der jetzt bei EMC arbeitet, einem Unternehmen, das sich auf die Verwaltung und Speicherung von Daten spezialisiert hat.

Allein einer der Kunden des Unternehmens, die New Yorker Börse, produziert täglich bis zu 2.000 Gigabyte an Daten, die über Jahre hinweg gespeichert werden müssen, fügte er hinzu.

EMC und die International Data Corporation schätzten gemeinsam, dass im vergangenen Jahr weltweit mehr als 1,8 Billionen Gigabyte an digitalen Informationen erzeugt wurden.

"Es ist ein regelrechter Wettlauf zwischen unserer Fähigkeit, Daten zu erzeugen, und unserer Fähigkeit, Daten zu speichern und zu verwalten", sagte Burton.

Nach Schätzungen von EMC wurden etwa drei Viertel dieser Daten von normalen Verbrauchern erzeugt.

Diese Verbraucher haben kein Gefühl dafür, dass Daten physisch sind oder dass ihre Speicherung Platz und Energie verbraucht, und haben die Gewohnheit entwickelt, riesige Datendateien wie Videos und Massen-E-Mails mit Fotoanhängen hin und her zu schicken. Selbst scheinbar alltägliche Handlungen wie das Ausführen einer App, um ein italienisches Restaurant in Manhattan oder ein Taxi in Dallas zu finden, erfordern, dass die Server eingeschaltet und bereit sind, die Informationen sofort zu verarbeiten.

Die Komplexität einer einfachen Transaktion ist für die meisten Nutzer ein Rätsel: Das Versenden einer Nachricht mit Fotos an einen Nachbarn könnte eine Reise durch Hunderte oder Tausende von Kilometern an Internetleitungen und mehrere Datenzentren erfordern, bevor die E-Mail auf der anderen Straßenseite ankommt.

"Wenn Sie jemandem sagen, dass er nicht auf YouTube zugreifen oder von Netflix herunterladen kann, wird er Ihnen sagen, dass das ein gottgegebenes Recht ist", so Bruce Taylor, Vizepräsident des Uptime Institute, einer Fachorganisation für Unternehmen, die Rechenzentren nutzen.

Um all diese digitalen Aktivitäten zu unterstützen, gibt es nach Angaben der International Data Corporation inzwischen weltweit mehr als drei Millionen Rechenzentren unterschiedlichster Größe.

Im Jahr 2010 verbrauchten Rechenzentren landesweit rund 76 Milliarden Kilowattstunden, was etwa 2 Prozent des gesamten Stromverbrauchs im Land entspricht. Dies geht aus einer Analyse von Jonathan G. Koomey hervor, einem Forschungsstipendiaten der Stanford University, der sich seit mehr als zehn Jahren mit dem Energieverbrauch von Rechenzentren beschäftigt. DatacenterDynamics, ein in London ansässiges Unternehmen, kam zu ähnlichen Zahlen.

Die Industrie argumentiert seit langem, dass die Computerisierung von Geschäftstransaktionen und alltäglichen Aufgaben wie Bankgeschäfte und das Lesen von Büchern in der Bibliothek unter dem Strich Energie und Ressourcen spart. Doch die Papierindustrie, deren Ablösung durch das Computerzeitalter von einigen vorausgesagt wurde, verbrauchte 2010 laut Zahlen des Census Bureau, die das Electric Power Research Institute für die Times überprüft hat, 67 Milliarden Kilowattstunden aus dem Netz.

Direkte Vergleiche zwischen den Branchen sind schwierig: Papier verbraucht zusätzliche Energie durch die Verbrennung von Zellstoffabfällen und den Transport der Produkte. In Rechenzentren werden ebenfalls Millionen von Laptops, Personalcomputern und mobilen Geräten eingesetzt.

Chris Crosby, Geschäftsführer des in Dallas ansässigen Unternehmens Compass Datacenters, sagte, es sei kein unmittelbares Ende der Ausbreitung der digitalen Infrastruktur in Sicht.

"Es gibt neue Technologien und Verbesserungen", sagte Crosby, "aber es läuft immer noch alles über ein Stromkabel."

Komatöse" Stromabzüge

Die Ingenieure von Viridity Software, einem Start-up-Unternehmen, das Unternehmen bei der Verwaltung von Energieressourcen unterstützt, waren nicht überrascht von dem, was sie auf dem Boden eines ausgedehnten Rechenzentrums in der Nähe von Atlanta entdeckten.

Viridity wurde an Bord geholt, um grundlegende Diagnosetests durchzuführen. Die Ingenieure stellten fest, dass die Einrichtung, wie Dutzende andere, die sie untersucht hatten, den Großteil ihres Stroms für Server verbrauchte, die kaum etwas anderes taten, als Strom zu verbrauchen, sagte Michael Rowan, der Chief Technology Officer von Viridity.

Ein leitender Beamter des Rechenzentrums hatte bereits den Verdacht, dass etwas nicht stimmte. Er hatte zuvor eine eigene informelle Untersuchung durchgeführt und Server, die er für "komatös" hielt, mit roten Aufklebern versehen - der Begriff, den Ingenieure für Server verwenden, die an das Stromnetz angeschlossen sind und Energie verbrauchen, obwohl ihre Prozessoren kaum oder gar keine Rechenarbeit leisten.

"Am Ende dieses Prozesses stellten wir fest, dass unser Rechenzentrum an den Masern erkrankt war", sagte der Beamte Martin Stephens während eines Web-Seminars mit Herrn Rowan. "Es gab so viele rote Markierungen, dass es unglaublich war."

Die Viridity-Tests bestätigten Herrn Stephens' Verdacht: Bei einer Stichprobe von 333 Servern, die 2010 überwacht wurden, erwies sich mehr als die Hälfte als komatös. Insgesamt nutzten fast drei Viertel der Server in der Stichprobe im Durchschnitt weniger als 10 Prozent ihrer Rechenleistung, um Daten zu verarbeiten.

Bei dem Betreiber des Rechenzentrums handelte es sich nicht um einen kleinen App-Entwickler oder ein Online-Glücksspielunternehmen, sondern um den Datenbankriesen LexisNexis. Und das war kein Einzelfall.

In vielen Einrichtungen werden Server mit Anwendungen beladen und auf unbestimmte Zeit laufen gelassen, selbst wenn fast alle Benutzer verschwunden sind oder neue Versionen der gleichen Programme anderswo laufen.

"Man muss bedenken, dass die Datenexplosion dies begünstigt", so Taylor vom Uptime Institute. "Ab einem bestimmten Punkt ist niemand mehr verantwortlich, denn niemand, absolut niemand, will in den Raum gehen und einen Server ausstecken."

Kenneth Brill, ein Ingenieur, der 1993 das Uptime Institute gründete, sagte, dass die geringe Auslastung mit der "Erbsünde" der Branche begann.

In den frühen 1990er Jahren, so Brill, stürzten Software-Betriebssysteme, die man heute als primitiv bezeichnen würde, ab, wenn sie zu viele Aufgaben zu erledigen hatten oder sogar ein- und ausgeschaltet wurden. Als Reaktion darauf ließen die Computertechniker selten mehr als eine Anwendung auf jedem Server laufen und hielten die Maschinen rund um die Uhr in Betrieb, ganz gleich, wie sporadisch diese Anwendung in Anspruch genommen wurde.

Während die Energieaufsichtsbehörden der Regierung die Verbraucher aufforderten, Computer auszuschalten, wenn sie nicht benutzt wurden, wurde die oberste Direktive in den Rechenzentren, Computer um jeden Preis laufen zu lassen.

Ein Absturz oder eine Verlangsamung könnte das Ende einer Karriere bedeuten, so Michael Tresh, ehemaliger leitender Beamter bei Viridity. In einem Bereich, der von Cleverness und Kühnheit geprägt war, regiert heute etwas anderes: die Angst vor dem Scheitern.

"Die Betreiber von Rechenzentren leben täglich in der Angst, ihren Arbeitsplatz zu verlieren", so Tresh, "und das liegt daran, dass das Unternehmen sie im Falle eines Ausfalls nicht unterstützen wird."

In der Fachsprache wird der Anteil der Gehirnleistung eines Computers, der für Berechnungen verwendet wird, als "Auslastung" bezeichnet.

McKinsey & Company, das Beratungsunternehmen, das die Auslastungszahlen für die Times analysiert hat, beobachtet das Thema seit mindestens 2008, als es einen Bericht veröffentlichte, der außerhalb der Branche kaum Beachtung fand. Die Zahlen sind hartnäckig niedrig geblieben: Die aktuellen Ergebnisse von 6 bis 12 Prozent sind nur geringfügig besser als die von 2008. Aufgrund von Vertraulichkeitsvereinbarungen ist McKinsey nicht in der Lage, die Unternehmen zu nennen, die in die Stichprobe einbezogen wurden.

David Cappuccio, Managing Vice President und Leiter der Forschungsabteilung des Technologieforschungsunternehmens Gartner, sagte, dass seine eigene, kürzlich durchgeführte Umfrage bei einer großen Anzahl von Rechenzentren eine typische Auslastung von 7 bis 12 Prozent ergab.

"Das ist die Art und Weise, wie wir Rechenzentren seit Jahren überdimensioniert und betrieben haben", sagte Cappuccio. "Dieses Maß an Komfort kostet eine Menge Geld. Es kostet eine Menge Energie."

Server sind nicht die einzigen Komponenten in Rechenzentren, die Energie verbrauchen. Industrielle Kühlsysteme, Schaltkreise zur Aufrechterhaltung des Ladezustands von Notstrombatterien und die einfache Verlustleistung in der umfangreichen Verkabelung tragen alle ihren Teil zum Energieverbrauch bei.

In einem typischen Rechenzentrum können diese Verluste in Verbindung mit einer geringen Auslastung dazu führen, dass die Energieverschwendung das 30-fache der Strommenge beträgt, die für den eigentlichen Zweck des Rechenzentrums verwendet wird.

Einige Unternehmen, akademische Organisationen und Forschungsgruppen haben gezeigt, dass weitaus effizientere Verfahren möglich sind, auch wenn es schwierig ist, verschiedene Arten von Aufgaben zu vergleichen.

Das National Energy Research Scientific Computing Center, das aus Clustern von Servern und Großrechnern am Lawrence Berkeley National Laboratory in Kalifornien besteht, war im Juli zu 96,4 Prozent ausgelastet, so Jeff Broughton, der Leiter des Betriebs. Die Effizienz wird erreicht, indem große Aufträge in eine Warteschlange gestellt und so geplant werden, dass die Maschinen 24 Stunden am Tag fast voll ausgelastet sind.

Das in Santa Clara ansässige Unternehmen Power Assure vermarktet eine Technologie, die es kommerziellen Rechenzentren ermöglicht, Server sicher abzuschalten, wenn sie nicht benötigt werden - zum Beispiel über Nacht.

Doch trotz aggressiver Programme, mit denen Silicon Valley Power seine Großkunden zum Energiesparen bewegen will, ist es nicht gelungen, auch nur ein einziges Rechenzentrum in Santa Clara zum Einsatz dieser Technik zu bewegen, so Mary Medeiros McEnroe, Managerin für Energieeffizienzprogramme bei dem Versorgungsunternehmen.

"In der IT-Gemeinschaft herrscht Nervosität darüber, dass etwas nicht zur Verfügung steht, wenn sie es brauchen", so McEnroe.

Die von Herrn Stephens für LexisNexis Risk Solutions durchgeführte Rationalisierung des Rechenzentrums ist ein Beispiel für die möglichen Einsparungen.

In der ersten Phase des Projekts sagte er, dass er durch die Konsolidierung der Arbeit auf weniger Servern und die Aktualisierung der Hardware eine 25.000 Quadratmeter große Einrichtung auf 10.000 Quadratmeter verkleinern konnte.

Natürlich müssen Rechenzentren jederzeit über eine gewisse Reservekapazität verfügen, und eine 100-prozentige Auslastung ist nicht möglich. Sie müssen darauf vorbereitet sein, Verkehrsspitzen zu bewältigen.

Herr Symanski vom Electric Power Research Institute sagte, dass solche niedrigen Wirkungsgrade nur in der obskuren Logik der digitalen Infrastruktur Sinn machen.

"Man sieht sich das an und fragt sich: Wie um alles in der Welt kann man ein Unternehmen so führen?", sagte Symanski. Die Antwort ist oft die gleiche, sagte er: "Sie bekommen keinen Bonus für die Einsparungen bei der Stromrechnung. Sie bekommen einen Bonus dafür, dass das Rechenzentrum 99,999 Prozent der Zeit verfügbar ist."

Die bestgeplanten Pläne

In Manassas im US-Bundesstaat Virginia betreibt der Einzelhandelsriese Amazon Server für seine Cloud inmitten eines LKW-Depots, eines stillgelegten Getreidesilos, eines Holzlagers und von Schrott übersäten Grundstücken, auf denen Maschinen Müllladungen für das Recycling komprimieren.

Die Server sind in zwei Amazon-Rechenzentren untergebracht, die in drei Gebäuden untergebracht sind, die wie sperrige Lagerhäuser mit grünen, gewellten Wänden aussehen. Luftschächte, die groß genug sind, um industrielle Kühlsysteme unterzubringen, ziehen sich über die Dächer; riesige Dieselgeneratoren stehen in Reihen um das Gebäude herum.

Der Begriff "Cloud" wird oft allgemein verwendet, um die Funktionen eines Rechenzentrums zu beschreiben. Genauer gesagt handelt es sich um einen Service zur Vermietung von Rechenkapazität. Diese Einrichtungen werden in erster Linie über das nationale Stromnetz versorgt, aber es sind fast immer Generatoren und Batterien vorhanden, um Strom zu liefern, wenn das Netz ausfällt.

Die Standorte in Manassas gehören zu den mindestens acht großen Rechenzentren, die Amazon in Nord-Virginia betreibt, wie aus den Unterlagen des Umweltministeriums von Virginia hervorgeht.

Die Behörde ist mit Amazon vertraut. Nach vier Inspektionen ab Oktober 2010 wurde dem Unternehmen mitgeteilt, dass die Behörde eine Geldstrafe in Höhe von 554.476 Dollar verhängen würde, weil es Dieselgeneratoren installiert und wiederholt betrieben hatte, ohne die für den Betrieb in Virginia erforderlichen Standard-Umweltgenehmigungen einzuholen.

Auch wenn es keine Stromausfälle gibt, stoßen die Notstromaggregate Abgase aus, da sie regelmäßig getestet werden müssen.

Nach monatelangen Verhandlungen wurde die Strafe auf 261.638 Dollar reduziert. Bei der Beurteilung des "Grades der Schuld" wurden alle 24 Verstöße als "hoch" eingestuft.

Drew Herdener, ein Sprecher von Amazon, stimmte zu, dass das Unternehmen "nicht die richtigen Genehmigungen" erhalten hatte, bevor die Generatoren eingeschaltet wurden. "Alle diese Generatoren wurden nachträglich genehmigt und zugelassen", sagte Herdener.

Die Verstöße kamen zu einer Reihe kleinerer Verstöße in einem der Rechenzentren von Amazon in Ashburn, Virginia, im Jahr 2009 hinzu, für die das Unternehmen laut den Aufzeichnungen der Behörde 3.496 Dollar zahlte.

Von all den Dingen, die vom Internet erwartet wurden, kann man mit Sicherheit sagen, dass eine Saat für die Verbreitung von Notstromdieselgeneratoren nicht dazu gehörte.

Terry Darton, ein ehemaliger Manager der Umweltbehörde von Virginia, sagte, dass in seinem 14 Bezirke umfassenden Bundesstaat Virginia so viele Generatoren für Rechenzentren genehmigt wurden, dass sie fast die Leistung eines Kernkraftwerks erreichen.

"Es ist schockierend, wie viel potenzielle Energie zur Verfügung steht", sagte Darton, der im August in den Ruhestand ging.

Es liegen keine landesweiten Zahlen über Umweltverstöße durch Rechenzentren vor, aber eine Überprüfung mehrerer Umweltbezirke deutet darauf hin, dass die Zentren allmählich die Aufmerksamkeit der Aufsichtsbehörden im ganzen Land auf sich ziehen.

In den letzten fünf Jahren erhielten beispielsweise die Internetkonzerne Savvis und Equinix im Großraum Chicago Verstöße, wie aus den Unterlagen der Illinois Environmental Protection Agency hervorgeht. Neben Amazon haben die Behörden in Nord-Virginia auch Rechenzentren von Qwest, Savvis, VeriSign und NTT America beanstandet.

Trotz aller Vorsichtsmaßnahmen - dem enormen Stromfluss, den Batteriebänken und dem Aufgebot an Dieselgeneratoren - kommt es immer wieder zu Pannen in den Rechenzentren.

Vor allem Amazon hatte in den letzten Jahren eine Reihe von Ausfällen in Nord-Virginia zu verzeichnen. Bei einem dieser Ausfälle, der im Mai 2010 in einer Anlage in Chantilly auftrat, waren Unternehmen, die von Amazons Cloud abhängig sind, nach Angaben des Unternehmens mehr als eine Stunde lang offline - eine Ewigkeit in der Datenbranche.

Die Ermittlung der Ursache wurde zu einer eigenen Informationspanne.

Amazon gab bekannt, dass der Ausfall ausgelöst wurde, als ein Fahrzeug gegen einen Hochspannungsmast auf einer Straße in der Nähe eines unserer Rechenzentren prallte".

Wie sich herausstellte, handelte es sich bei dem Autounfall um einen Mythos, ein Missverständnis, das von einem örtlichen Elektrizitätswerker über einen Mitarbeiter des Rechenzentrums bis hin zur Amazon-Zentrale weitergegeben wurde. Stattdessen sagte Amazon, dass seine Backup-Ausrüstung irrtümlich einen Teil des Rechenzentrums abgeschaltet hat, nachdem Dominion Virginia Power sagte, dass es sich um einen Kurzschluss an einem Strommast handelte, der zwei kurzzeitige Ausfälle verursachte.

Herr Herdener von Amazon sagte, dass das Backup-System überarbeitet worden sei und dass "wir nicht erwarten, dass sich dieser Zustand wiederholt".

Die Ursache des Problems

Letztes Jahr wurde im Nordosten eine 1 Milliarde Dollar teure Zuleitung für das nationale Stromnetz in Betrieb genommen, die sich etwa 215 Meilen vom Südwesten Pennsylvanias durch die Allegheny Mountains in West Virginia schlängelt und in Loudon County, Virginia, endet.

Die Arbeiten wurden von Millionen von Steuerzahlern finanziert. Steven R. Herling, ein leitender Beamter bei PJM Interconnection, einer regionalen Behörde für das Stromnetz, sagte, dass die Notwendigkeit, die wie Pilze aus dem Boden schießenden Rechenzentren in Nord-Virginia zu versorgen, den Ausschlag für das Projekt in einer ansonsten schwachen Wirtschaft gegeben habe.

Laut Jim Norvelle, einem Sprecher von Dominion Virginia Power, dem größten Energieversorger der Region, verbrauchen die Rechenzentren in diesem Gebiet inzwischen fast 500 Millionen Watt Strom. Dominion schätzt, dass der Verbrauch in den nächsten fünf Jahren auf mehr als eine Milliarde Watt ansteigen könnte.

Rechenzentren gehören zu den begehrtesten Kunden der Versorgungsunternehmen. Viele Versorgungsunternehmen im ganzen Land werben um diese Einrichtungen, weil sie fast rund um die Uhr Strom verbrauchen. Ein großer, gleichmäßiger Verbrauch ist für die Versorgungsunternehmen rentabel, da sie so ihre eigenen Stromkäufe im Voraus planen und ihre Dienstleistungen nachts vermarkten können, wenn die Nachfrage anderer Kunden sinkt.

Bramfitt, der ehemalige Geschäftsführer eines Versorgungsunternehmens, befürchtet, dass diese Dynamik eine verschwenderische Industrie dazu ermutigt, an ihren Gewohnheiten festzuhalten, das Gaspedal durchzutreten. Selbst bei all der Energie und Hardware, die in das Feld fließen, glauben andere, dass es für die derzeitigen Methoden der Datenspeicherung und -verarbeitung eine Herausforderung sein wird, mit dem digitalen Tsunami Schritt zu halten.

Einige Branchenexperten glauben, dass die Lösung in der Cloud liegt: die Zentralisierung der Datenverarbeitung in großen und gut betriebenen Datenzentren. Diese Rechenzentren würden sich stark auf eine Technologie namens Virtualisierung stützen, die es Servern ermöglicht, ihre Identitäten zu großen, flexiblen Rechenressourcen zu verschmelzen, die je nach Bedarf an die Benutzer verteilt werden können, egal wo sie sich befinden.

Einer der Befürworter dieses Ansatzes ist Herr Koomey, der Experte für Rechenzentren aus Stanford. Er sagte jedoch, dass viele Unternehmen, die versuchen, ihre eigenen Rechenzentren zu verwalten, entweder im eigenen Haus oder in gemieteten Räumen, immer noch nicht mit der neuen Cloud-Technologie vertraut sind oder ihr misstrauisch gegenüberstehen. Leider sind diese Unternehmen für den Großteil des Energieverbrauchs von Rechenzentren verantwortlich, so Koomey.

Andere äußern eine tiefe Skepsis gegenüber der Cloud und sagen, dass der manchmal mystisch klingende Glaube an ihre Möglichkeiten durch die physische Beschaffenheit der Infrastruktur, die für ihre Unterstützung erforderlich ist, widerlegt wird.

Durch die Nutzung der Cloud ändert sich lediglich der Ort, an dem die Anwendungen ausgeführt werden", so Hank Seader, leitender Direktor für Forschung und Ausbildung beim Uptime Institute. "Alles läuft irgendwo in einem Rechenzentrum".

Manche fragen sich, ob die Sprache des Internets selbst ein Hindernis für das Verständnis ist, wie physisch es ist und wahrscheinlich auch bleiben wird. Nehmen wir zum Beispiel die Frage der Datenspeicherung, sagte Randall H. Victora, ein Professor für Elektrotechnik an der Universität von Minnesota, der über magnetische Speichergeräte forscht.

"Wenn jemand sagt: 'Ich speichere etwas in der Cloud, dann brauchen wir keine Festplatten mehr' - dann ist die Cloud ein Festplattenlaufwerk", so Victora. "Wir bekommen sie auf die eine oder andere Weise. Wir wissen es nur nicht."

Was auch immer in den Unternehmen geschieht, es ist klar, dass die Erwartungen der Verbraucher den Bedarf an einer solch gewaltigen Infrastruktur weitgehend bestimmen.

"Das ist es, was das massive Wachstum antreibt - die Erwartung der Endnutzer, alles, jederzeit und überall nutzen zu können", sagt David Cappuccio, Managing Vice President und Leiter der Forschungsabteilung des Technologieforschungsunternehmens Gartner. "Wir sind die Verursacher des Problems".